¿Qué es el reinforcement learning?

Reinforcement Learning (RL) o aprendizaje por refuerzo es un acercamiento computacional al aprendizaje obtenido de la interacción. El cuál esta dirigido a un objetivo. Es aprender qué hacer - como mapear situaciones a acciones - .

El aprendiz debe descubrir que acciones dan la mayor recompensa al ejecutarlas.

- Prueba y error.

- Recompensa retardada.

Son las dos carácteristicas más importantes que distinguen al RL. El tipo de problemas que estudia son aquellos que se formalizan como un Proceso de desición de Markov en el cual se modelizan como un agente es capaz de sentir el estado del ambiente y en cierto grado debe poder tomar acción que afecte ese estado. Y cualquier método bien estudiado que resuelva tales problemas son considerados un método de RL.

Elementos

Política: Define el comportamiento del agente en un paso de tiempo dado. Es un mapeo de los estados percibidos a las acciones a tomar cuando está en esos estados.

Señal de recompensa:Define el objetivo. Esta señal define los eventos buenos y malos para el agente. El objetivo del agente es maximizar la recompensa total que recibe a largo plazo.

Función de valor: Especifica que es bueno en el largo plazo. Mapea cada estado a un valor númerico. El valor de un estado es la cantidad total de recompensa que el agente puede eserar acumular en el futuro, empezando en ese estado.

Modelo: Algo que simula el comportamiento del ambiente o que permite hacer inferencias de como el ambiente se comportará. Los modelos son usados para planear, es decir, decidir un curso de acción considerando las posibles situaciones antes de ser experimentadas.

Observaciones:

En el RL moderno hay métodos en el espectro desde bajo nivel, prueba y error, a alto nivel, planeación deliberada. Es decir, el modelo es opcional.

Mientras que la recompensa determina lo deseable de manera inmediata que son los estados del ambiente, los valores indican lo deseable que son a largo plazo después de tomar en cuenta los estados que son probables de seguir y las recompensas disponibles en esos estados.

Procesos de desición de Markov finitos

Los Markov Decision Process (MDP) son una formalización clásica de una sucesión de toma de decisiones, donde las acciones influencian no solo la recompensa inmediata, sino a las situaciones subsequentes o estados, y a así a las recompenzas futuras.

El aprendiz y el que toma decisiones es llamado el agente.

La cosa con la que se interactua, comprendiendo todo lo que está fuera del agente, es llamado el ambiente.

El ambiente también da la recompensa, valores espaciales númericos que el agente busca maximizar a tráves de la elección de acciones.

El agente y el ambiente interactuán en cada paso de tiempo

Un paso de tiempo después, en parte como una consecuencia de su acción, el agente recibe una recompensa que es un número

En este caso los conjuntos

Como

La probabilidad de cada valor posible para

A partir de la función dinámica de cuatro argumentos,

Hipótesis de recompensa

"Todo lo que entendemos por objetivos y propósitos puede entenderse como la maximización del valor esperado de la suma acumulada de una señal escalar recibida (llamada recompensa)."

Devoluciones y episodios

Formalicemos la idea de que el objetivo del agente es maximizar la recompensa acumulada en el largo plazo. Dado el paso de tiempo

Por otra parte exsiten las tareas continuas que siguen continuamente sin limite que no tienen estado terminal, es decir que

Notemos que si

Algo importante es que

Política y función de valor

Formalmente la política es un mapeo de los estados a las probabilidades de seleccionar cada posible acción. Si el agente sigue una política

Los métodos de reinforcement learning especifican como la política del agente cambia dada su experiencia.

La función de valor de un estado

Similarmente, definimos el valor al tomar una acción

Ecuaciones de Bellman

Una propiedad fuindamental que resulta que tienen las funciones de valor es una relación recursiva, llamada ecuación de Bellman, para cualquier política

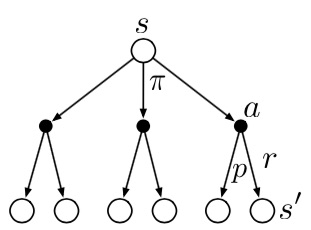

Piense en mirar hacia adelante desde un estado a sus

posibles estados sucesores, como lo sugiere el diagrama. Cada círculo abierto representa un estado y cada círculo sólido

representa un par estado-acción. A partir del estado

Estas operaciones transfieren información del valor al estado (o par estado-acción) de sus estados sucesores (o par estado-acción).

Políticas óptimas y funciones de valor óptimas

Resolver una tarea de aprendizaje por refuerzo significa, en líneas generales, encontrar una política que logre una gran recompensa a largo plazo. Para MDP finitos, podemos definir con precisión una política óptima de la siguiente manera. Las funciones de valor definen un ordenamiento parcial de las políticas.

Definición. Una política

Siempre hay al menos una política que es mejor o igual a todas las demás políticas. Esta es una política óptima. Aunque puede haber más de una, denotamos todas las políticas óptimas por

Las políticas óptimas también comparten la misma función de valor de acción óptima, denotada

Como

Solución análitica a la ecuación

Para MDP finitos, la ecuación de optimalidad de Bellman paraEncontrar la política óptima

Una vez que se tiene

Solución aproximada

La solución explícita de la ecuación de optimalidad de Bellman ofrece una vía para encontrar una política óptima y, por tanto, para resolver el problema del aprendizaje por refuerzo. Sin embargo, esta solución rara vez resulta directamente útil. Es similar a una búsqueda exhaustiva, en la que se analizan todas las posibilidades y se calculan sus probabilidades de ocurrencia y sus deseabilidades en términos de recompensas esperadas. Esta solución se basa en al menos tres supuestos que rara vez son ciertos en la práctica:

(1) conocemos con precisión la dinámica del entorno;

(2) tenemos suficientes recursos computacionales para completar el cálculo de la solución;

y (3) la propiedad de Markov.

Para los tipos de tareas que nos interesan, por lo general no es posible implementar esta solución con exactitud porque se violan varias combinaciones de estos supuestos. Por ejemplo, aunque el primer y el tercer supuesto no presentan problemas para el juego de backgammon, el segundo es un impedimento importante. Como el juego tiene alrededor de