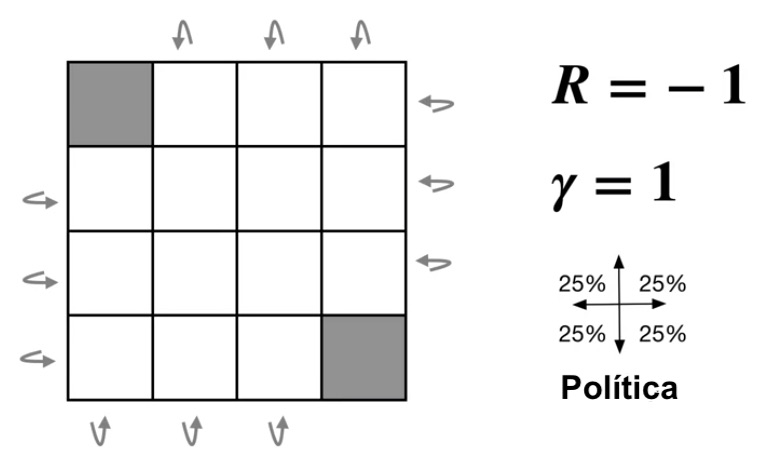

Un ejemplo de un MDP finito episódico sería un agente que está en una cuadrícula rectangular de

Notemos que la función

Recordemos que resolver este MDP significa encontrar una política óptima, para podemos usar directamente el algoritmo de iteración de valor, pero para visualizar los resultados de la mejora, usemos primero evaluación de política y luego mejora de política y finalmente iteración valor.

Evaluación de política

Para ello primero de evaluemos la política que esta dada por la ditribución uniforme que es la que aparece en la imagen, es decir:

Inicialicemos la función de valor a

t = 0

Después de varias iteraciones deja de notarse un cambio en los valores, ya que el cambio es muy pequeño y por simplicidad se redondean a tres decimales.

Mejora de política

Una vez que tenemos la función de valor para una política dada, como se hace la sección previa, podemos obtener una mejor política partir de está función. Actuando codiciosamente sobre dicha función.

Si en la sección anterior hemos iterado lo suficiente, la política generada es la óptima.

Iteración de evaluación y mejora de política

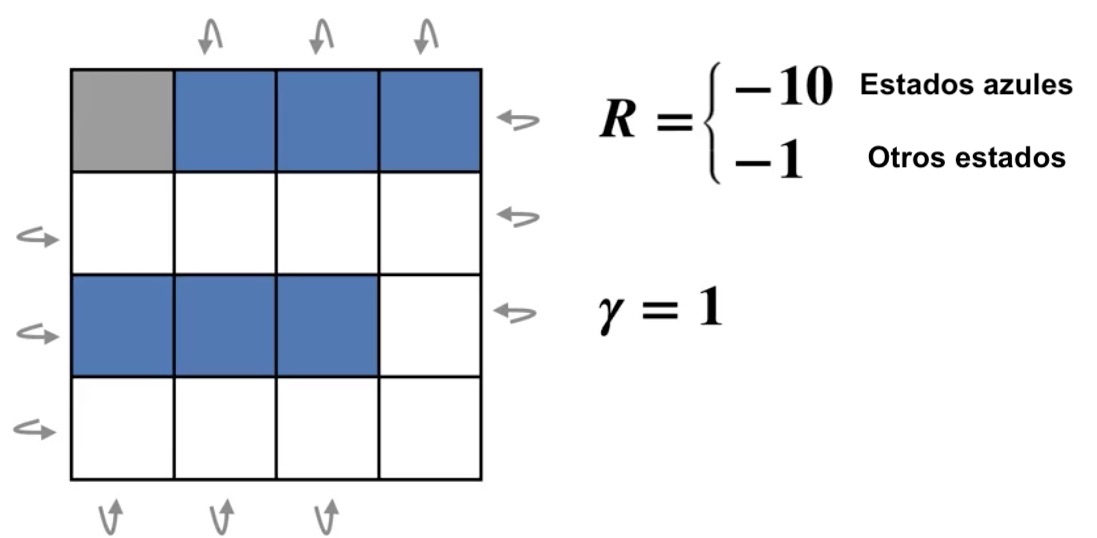

Modifiquemos nuestro MDP para que sea más interesante: en el cual quitamos un estado terminal y agregamos estados malos.

Podemos hacer las dos cosas anteriores de manera que iniciando con una política dada podemos obtener su función de valor, y después generar una política mejor, luego obtener su función de valor correspondiente y volver a empezar hasta que la política enésima ya no cambie.

La función de valor y la política son inicializadas arbitrariamente. En este caso la política de inicializa con la política uniforme para las cuatgro acciones. Y la función de valor en

Iteración de valor

En la sección anterior se puede proceder de dos formas:

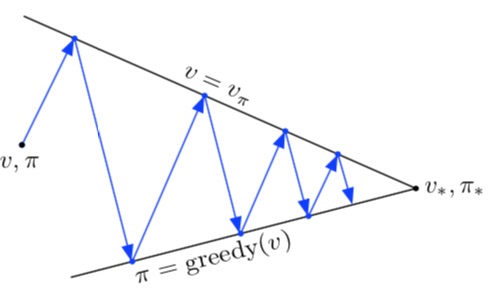

La primera opción se puede visualizar de manera intuitiva como:

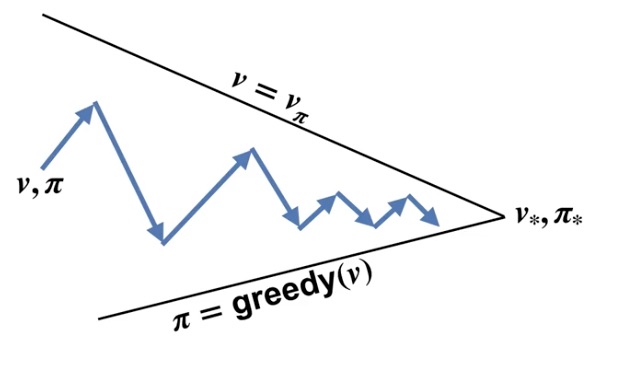

A la segunda opción se le llama iteración de valor. Y se puede ver visualizar en la siguiente figura.

Esta opción suele converger más rápido a la política óptima.

Esta opción suele converger más rápido a la política óptima.

Claro que se puede automatizar la realización de las iteraciones añadiendo un parámetro para saber cuando parar y tengamos cierta presición. Podemos parar cuando la diferencia de la función de valor actual con la del paso anterior sea más pequeña que un número positivo pequeño.